4. 突破认知局限

有些朋友们可能到这里就坐不住了,脑子里开始构思所在行业应该如何操作

可是,万一你所在的行业没有蓝海流量呢?为什么一定要在你熟悉的领域做呢?

流量高手的思维,从来都是大盘思维,即以全局的视野来思考问题

而此次,我们要分析知乎整体搜索流量的分布,哪里有蓝海流量,我们就去到哪,而不只局限于某个问题,某个行业

甚至知乎好物完全可以基于蓝海流量的思维

始终记住我们的目的只有一个,那就是赚钱

同时,这也是我写【TACE】(Traffic ACE,流量高手)这个公众号的主要思想,只不过后来去折腾项目,很少发文,咳咳….

前面讲了不少内容,那是因为我想把“道”这个层面讲清楚,即为什么这么干;而“法”是死的,规则发生变化,方法立即失效

举个例子:特斯拉诞生之初,电池成本比当时市面上低了10倍,CEO马斯克为什么能做到?

那是因为他的道是“物理学思维”,把事物拆解成最小单元寻求解决方案(TED有演讲)

但是,80%的人都喜欢直接得到方法,why?

爸爸说他听爷爷的姥爷说过,在几十万年前,人类还在狩猎阶段的时候,为了存活下去,才诞生了大脑

而大脑的进化需要上百万年,人类诞生历史不过才二十万年左右,也就是说现在我们还是用着“旧脑子”

其中“旧脑子”一个显著的特点是最小作用力原理,人类天生会默认做出消耗脑力低的行为,即能不用脑就不用脑,而道理的学习用脑程度较高

包括我,每当自己懒得动脑的时候,我就嘲讽自己是个原始人,咳咳…

那么下面,就让我们一步步的进入“战场”

5. 打造百万级词库

词库是用户搜索词和词属性的集合

我们尽可能的收集N个渠道的关键词,因为每个渠道或第三方平台都有他的局限性

在流量高手眼里,词库里躺的不是一个个的关键词,而是一张张的RMB

以搜索流量的视角来看,在大多数情况下,加词等于加流量

你能找到别人找不到的词,你就能拿到别人拿不到的流量,从而赚到别人赚不到的钱

关于数据的储存格式,个人建议直接使用csv形式,以逗号为分隔符的本地文件储存,相比于mysql类的数据库,用Bash shell来查询和分析不要太方便

拿词渠道:

5118,爱站,站长之家。

下面我用5118举例

5.1 母词获取

1)5118

分别下载百度PC关键词和移动关键词,分开处理

没有会员的朋友自行淘宝,有企业版的朋友建议全量导出

接下来的步骤,我们会开始涉及一些编程知识:

Bash shell(Linux) + Python

因为此次数据计算的需求常规工具已经不能满足,所以我们要动用“神秘”的编程力量

我自己已经全部开发完毕,部分简单的Bash shell命令行直接在文章内给出

但是我相信就这一点会让80%的人知难而退,可是包括我,谁又不是从小白一步步走过来的呢?

编程真的没有那么难,trust me!如果可以,告诉自己做那20%

另外请记住,我们不是要成为一个专业的程序员,编程能力能满足我们当前所需就好

2)初始处理

转码(GBK > UTF-8),因为5118给出的数据编码是GBK,而Linux里需要UTF-8

只输出关键词,不使用其他数据,因为第三方数据的准确度实在差强人意,像5118这种量级每天的更新量少说也要1亿,成本摆在这。

获取前100名第一因为数据准度低,后面我们要自己验证数据第二前面提到过动态排名 & 百度提权,在你获取数据和验证数据中间存在时间差,在时间差里排名可能已经发生了变化。

bash shell:

cat 输入文件名| iconv -c -f GB18030 -t utf-8| grep -Ev "整域百度PC关键词排名列表|百度指数|100以外"|awk -F, '{print $1}' > 输出文件名

3)关键词清理

特殊符号

[\s+\.\!\?\/_,$%^*()+\"\']+|[+——!,::。√?、~@#¥%……&*()“”《》~]

非常容易忽视的一步,很多人天然信任不同渠道产出的关键词数据(包括百度),但是“流量高手,”与“流量高手”的搜索量数据差了十万八千里

网址

www|com|cn|cc|top|net|org|net|cn|rog|cn|tv|info|wang|biz|club|top|vip

年份替换,例如2010年替换为2020年

中文长度 >=2 (可选)

4)去敏感词

非法词汇你懂得,这里我们使用了DFA算法,平均处理一个关键词不到0.1s

5) 去重

去重是非常重要的一步,但对内存要求比较高,也就是说你要去重的文件大小不能超过可使用内存大小

目前的解决方法是用sort + uniq,先用split将目标文件分割,然后用sort逐个排序,然后sort+uniq合并去重

虽然没有大幅减少内存使用大小,但提升了计算效率

bash shell 简版:

cat 输入文件名 | sort | uniq > 输入文件名

bash shell 大数据版:

#!/bin/bash#命令行参数:#$1 输入文件#$2 输出文件basepath=$(cd `dirname $0`; pwd)echo `date` "[wordsUniq.sh DEBUG INFO] 开始文件分割..."split -l300000 $1 ${basepath}/words_split/split_ #文件分割echo `date` "[wordsUniq.sh DEBUG INFO] 开始单个排序..."for f in `ls ${basepath}/words_split/`dosort ${basepath}/words_split/${f} > ${basepath}/words_split/${f}.sort #单个排序doneecho `date` "[wordsUniq.sh DEBUG INFO] 开始合并去重..."sort -sm ${basepath}/words_split/*.sort|uniq > $2echo `date` "[wordsUniq.sh DEBUG INFO] 删除缓存数据..."rm ${basepath}/words_split/*

使用方法:

储存为filename.sh文件,在当前目录创建words_split文件夹,然后使用如下命令行,输入输出文件均可指定路径

sh 脚本名称.sh 输入文件 输出文件

OK,处理完毕,现在我们已经得到了两份非常“干净”的母词数据,即知乎百度PC关键词和移动关键词

5.2 词扩展

词扩展即对获得的母词进行扩展,因为一个页面可能命中多个相关的关键词

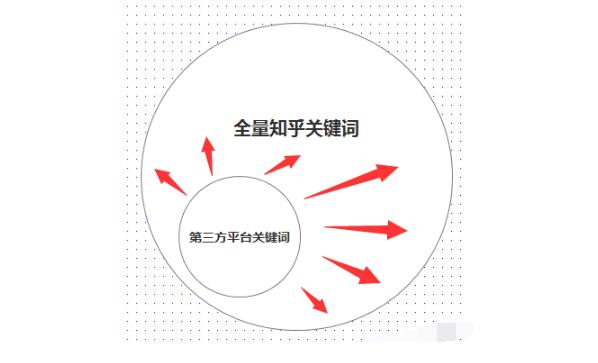

进而我们可以假设,从第三方平台获取的词只是他们所能找到的,当前知乎所能命中的词的子集

我们要尽可能的把其他部分的词找出来,从而比较准确的预估一个问题页面的百度流量

假设现在有A和B两个问题,在你的词库中,A命中50个关键词,总流量为1W,B命中10个关键词,流量为100

那么你可能将B问题忽略掉,只处理A问题

可是,B问题实际上命中了100个关键词,流量为10W

这样由于数据的不完整性造成了信息差,进而直接错过了获取这些流量的机会

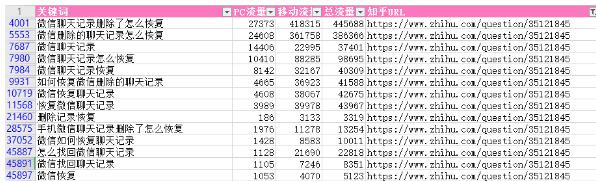

举个例子:

经过扩展,这个页面共命中47个关键词,PC+移动总流量为132W,广告太多知乎被迫风控提醒,下面是展示该部分数据

怎么样,是不是开始慢慢感受到数据的魅力了?打起精神,Let’s keep going!

由于只做百度流量,下面只使用百度来扩展

1)相关搜索 + 下拉框词抓取

很多人只知道抓这两个渠道,并不知道这两个渠道的性质:

相关搜索

相关搜索为横向扩展,大部分为跨关键词主题的相关扩展,其中可能出现主题严重漂移的情况,为保证相关性,只抓取一轮

下拉框

下拉框为纵向扩展,大部分在关键词的结尾追加词缀

阐明渠道性质的意义在于,关键词这种文本数据,扩展方向有且只有这两个,其他扩展渠道方法都是这两个基本方向的叠加或者变种

因为不同端产出的数据可能不同,所以我们要把PC端和移动端的母词,分别进行同端口的扩展

即PC母词抓PC相关搜索 + PC下拉框,移动母词抓移动相关搜索 + 下拉框

2)百度推广后台词扩展

路径为:注册/登录 > 进入搜索推广 > 推广管理 > 关键词规划师 > 关键词

注册免费,另外你还可以使用艾奇SEM工具/斗牛SEO工具等

3)词处理

先将各个渠道的词分端口合并

bash shell:

cat file1.txt file2.txt > all.txt

然后重复【5.1母词获取】的关键词清理和去重部分

5.3 获取关键词流量

同样使用到百度推广后台的关键词规划师,但使用的是“流量查询”的功能

这是百度官方给出的流量数据,以前的数据口径是日搜索量,现在变成了月搜索量,不过并无大碍

有的朋友可能产生疑问,为什么不先抓排名筛选数据,减轻下一步的数据量压力?

因为关键词规划师一次能查询1000个!10W个关键词只需查询100次!

并且实测证明获取一次cookie可跨天使用,并保持10+个小时的有效登录(答应我,请务必下手轻一点)

1)流量数据获取

通过模拟登录的方式post关键词数据

2)数据筛选

每个端只保留搜索量 >= N的关键词(数值自定义)

你可以在数据获取的同时去做筛选,也可以拆开另做一个筛选步骤,这里个人建议后者,万一指标不合理还有重新筛选的余地

bash shell:

cat file.txt | awk -F, '{$2>=100}' > file_new.txt

5.4 获取关键词排名

分别获取各端的排名数据,只保留

https://www.zhihu.com/question/{问题ID}

这个url特征下,前10名的关键词,以及储存对应的问题url

5.5 可获取流量

关键词流量并不等于知乎问题页面能获取的实际流量

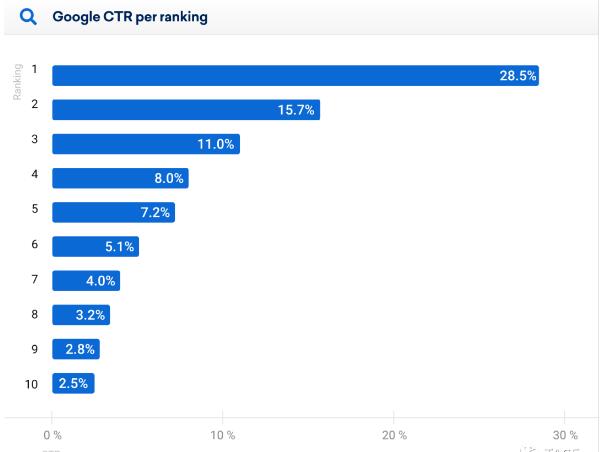

前面提到过,搜索流量在到达页面之前还有一个点击的步骤,所以我们应该把可获取流量计算出来,公式为:

可获取流量 = 流量 X 点击率

点击率根据排名估算,但是百度似乎从来没有发布过点击率数据,咳咳…

但是我们找到了一份Sistrix在2020年7月14日发布的google点击率数据,该数据分析了超过8000万的关键字和数十亿的搜索结果

虽然只是移动端的统计,但并无大碍

原文(英文):

https://www.sistrix.com/blog/why-almost-everything-you-knew-about-google-ctr-is-no-longer-valid/

每个关键词的可获取流量计算完成后,我们的词库就搭建完毕了,Niceee!

2000万的知乎蓝海流量掘金机会(上)

2000万的知乎蓝海流量掘金机会(中)

2000万的知乎蓝海流量掘金机会(下)

来源【运营官微圈】自媒体,更多内容/合作请关注「辉声辉语」公众号,送10G营销资料!